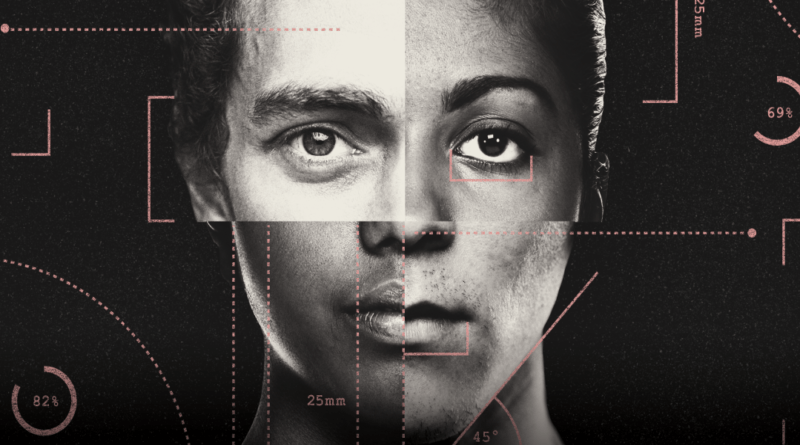

Les algorithmes d’IA classent notre attractivité

Les scores de beauté, dit-elle, font partie d’une dynamique inquiétante entre une culture de la beauté déjà malsaine et les algorithmes de recommandation que nous rencontrons chaque jour en ligne. Lorsque les scores sont utilisés pour décider des publications qui seront diffusées sur les plateformes de médias sociaux, par exemple, cela renforce la définition de ce qui est jugé attractif et détourne l’attention de ceux qui ne correspondent pas à l’idéal strict de la machine. «Nous restreignons les types d’images disponibles pour tout le monde», déclare Rhue.

C’est un cercle vicieux: avec plus de regards sur le contenu mettant en vedette des personnes attrayantes, ces images sont capables de susciter un engagement plus élevé, de sorte qu’elles sont montrées à encore plus de personnes. Finalement, même si un score de beauté élevé n’est pas une raison directe pour laquelle un message vous est montré, c’est un facteur indirect.

Dans une étude publiée en 2019, elle a examiné comment deux algorithmes, l’un pour les scores de beauté et l’autre pour les prédictions d’âge, affectaient l’opinion des gens. On a montré aux participants des images de personnes et on leur a demandé d’évaluer la beauté et l’âge des sujets. Certains des participants ont vu le score généré par une IA avant de donner leur réponse, tandis que d’autres n’ont pas du tout montré le score de l’IA. Elle a constaté que les participants sans connaissance de la cote de l’IA ne présentaient pas de biais supplémentaire; Cependant, en sachant comment l’IA classait l’attractivité des gens, les gens donnaient des scores plus proches du résultat généré par algorithme. Rhue appelle cela «l’effet d’ancrage».

«Les algorithmes de recommandation modifient en fait nos préférences», dit-elle. «Et le défi d’un point de vue technologique, bien sûr, est de ne pas trop les restreindre. En ce qui concerne la beauté, nous constatons un rétrécissement bien plus important que je ne l’aurais imaginé. »

« Je n’ai vu aucune raison de ne pas évaluer vos défauts, car il existe des moyens de les corriger. »

Shafee Hassan, Studio Qoves

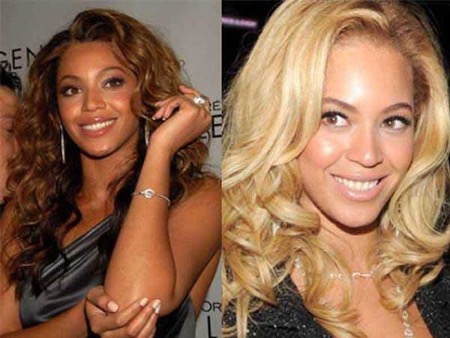

Chez Qoves, Hassan dit qu’il a essayé de s’attaquer de front au problème de la course. Lors de la réalisation d’un rapport d’analyse faciale détaillé – le type pour lequel les clients paient – son studio tente d’utiliser des données pour catégoriser le visage selon l’ethnicité afin que tout le monde ne soit pas simplement évalué par rapport à un idéal européen. «Vous pouvez échapper à ce biais eurocentrique simplement en devenant la meilleure version de vous-même, la plus belle version de votre appartenance ethnique, la plus belle version de votre race», dit-il.

Mais Rhue se dit préoccupée par le fait que ce type de catégorisation ethnique soit intégré plus profondément dans notre infrastructure technologique. «Le problème, c’est que les gens le font, peu importe la façon dont nous les regardons, et il n’y a aucun type de réglementation ou de surveillance», dit-elle. «S’il y a un type de conflit, les gens essaieront de savoir qui appartient à quelle catégorie.»