Le documentaire « Coded Bias » de Netflix révèle les préjugés raciaux dans la technologie

Source: John Lund / Getty

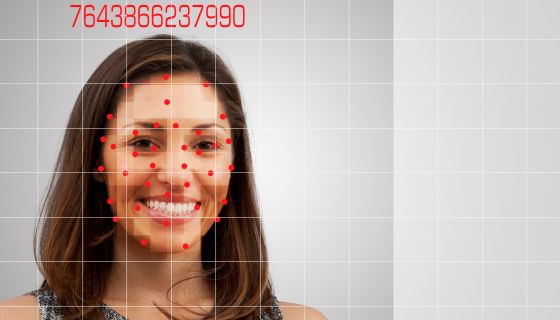

Coded Bias, le nouveau Netflix documentaire, explore les technologies racistes, y compris la reconnaissance faciale et les algorithmes est à surveiller.

Le film s’ouvre avec Joy Buolamwini, une chercheuse du MIT qui a découvert des préjugés raciaux dans plusieurs grands programmes de reconnaissance faciale. Il y a trois ans, Buolamwini trouvé Les logiciels de reconnaissance faciale disponibles dans le commerce présentaient un préjugé racial et sexiste inhérent. Dans Coded Bias, Buolamwini explique comment elle a découvert le problème. En examinant les ensembles de données utilisés pour entraîner le logiciel, elle a découvert que la plupart des visages utilisés étaient des hommes blancs.

L’histoire de Buolamwini sert de point de départ pour discuter de la discrimination à travers différents types de technologies et de pratiques de données. Coded Bias documente plusieurs exemples de la façon dont l’efficacité technologique ne conduit pas toujours à ce qui est moralement correct.

Un de ces incidents concerne des voisins dans un immeuble de Brooklyn où le propriétaire a tenté de mettre en œuvre un logiciel de reconnaissance faciale. Locataires du Appartements Atlantic Towers à Brownsville poursuivi pour empêcher ce qu’ils ont appelé une intrusion dans la vie privée.

Le documentaire a également souligné les efforts déployés à l’étranger pour résoudre les problèmes liés au racisme technologique. Dans une scène, la police britannique a mal identifié et détenu un étudiant noir de 14 ans utilisant un logiciel de reconnaissance faciale. La police britannique a empêché un autre homme de se couvrir le visage parce qu’il ne voulait pas que le logiciel le scanne.

En un peu moins de 90 minutes, Coded Bias décompose la complexité du racisme technologique. Le racisme dans les algorithmes, en particulier lorsqu’ils sont utilisés par les forces de l’ordre, retient de plus en plus l’attention. Alors que plusieurs villes ont interdit l’utilisation de tels logiciels, Detroit a continué à aller de l’avant.

En juin de l’année dernière, le chef de la police de Detroit reconnu le logiciel a mal identifié les personnes environ 96% du temps. En trois mois, le conseil municipal a renouvelé et élargi sa relation avec le fabricant de technologie en ignorant l’erreur flagrante.

Le département de police de New York réclamé précédemment d’avoir une utilisation limitée des logiciels de Clearview AI. Mais une enquête récente de Buzzfeed a montré que le NYPD faisait partie des milliers d’agences gouvernementales qui utilisaient les produits Clearview AI. Les agents ont effectué environ 5 100 recherches à l’aide d’une application de la société de technologie.

La reconnaissance faciale et les pratiques de données biaisées existent dans plusieurs secteurs. Les algorithmes et autres technologies peuvent assumer les hypothèses erronées et les préjugés inhérents à la société. En février, Data 4 Black Lives lancé #NoMoreDataWeapons pour sensibiliser à l’utilisation des données et d’autres formes de technologie pour surveiller et criminaliser les Noirs.

Cela rappelle la pièce incroyablement puissante de @culturejedi au @EFFSite Web de https://t.co/bleuZvbaBY https://t.co/FJI7RkbyKr

– Documentaire sur les biais codés (@CodedBias) 9 avril 2021

De même, MediaJustice s’est organisé autour de l’équité dans la technologie et les médias, y compris la surveillance électronique et la protection de la dissidence noire. Lors d’une séance de questions-réponses la semaine dernière avec le compte Twitter Coded Bias, MediaJustice, qui a cartographié les points chauds de surveillance électronique à travers le pays, a souligné l’utilisation de la technologie de surveillance, y compris un logiciel de reconnaissance faciale, pour suivre les manifestants.

Aussi sur NewsOne:

21 photos